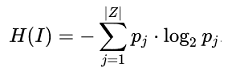

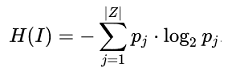

In der - technischen - Kommunikationstheorie wird der Informationsgehalt einer Nachricht durch eine Formel bestimmt, die in der Physik für eine physikalische Grösse - also für etwas ganz anderes - verwendet wird.

Dieselbe Formel hat zwei ganz verschiedene Kontexte. Sie wird aber in beiden Kontexten als Formel zur Bestimmung von Entropie bezeichnet, wodurch das Wort Entropie auch zwei völlig verschiedene Bedeutungen bekommt - die hochabstrakt mit "Unsicherheit" oder "Unordnung" in Verbindung gebracht wird.

|

C. Shannon verwendet die Formel von R. Hartley zur Berechnung dessen, was er als Informationsgehalt bezeichnet.

C. Shannon's Co-Autor W. Weaver hat diese "Entropie-Formel" dann anhand eines Kartenspiels veranschaulicht:

Wenn ich herausfinden muss, was mein Gegenüber für eine Spielkarte gezogen hat (und ich weiss, dass es sich um eine Karte eines Pokerspiels mit 52 Karten (vier Farben (♣ Kreuz ♥ Herz ♠ Pik ♦ Karo) und dreizehn Werten (2 bis 10 − Bube − Dame − König − Ass), handelt), kann ich blindling raten oder systematisch Fragen stellen: rot oder schwarz, dann Herz oder Karo, dann 2-8 oder grösser, dann grösser als 4, dann grösser als 2, dann 3 oder 4. Ich brauche also - in diesem Fall - 6 Fragen, um die Karte zu identifizieren. Ich kann leicht erkennen, dass es auf die Menge der Karten ankommt. Bei 2 verschiedenen Karten müsste ich nur 1 Frage stellen. Es kommt aber - ebenso leicht erkennbar - nicht nur auf die Menge der Karten an, sondern auch auf die Struktur der Kartenmenge - also auf deren relatives Strukturniveau.

Ein Datum hat einen Informationsgehalt, der als eine Anzal Bit angegeben wird. 5 Bit bedeutet mehr Information als 3 Bit und in der Shannon-Redeweise eine höhere Entropie. Ich muss mehr Fragen stellen, wenn ich die Antwort nch nicht weiss, was Shannon als höhere Unordnung begriffen hat. ================Der negative Logarithmus bewirkt, dass das Resultat für den gesunden Menschenverstand plausibel ist. Wenn ich 5 Fragen stellen muss, ist die gemeinte "Entropie" eben grösser als wenn ich 3 Fragen stellen muss.

Siehe dazu auch Redundanz |

|