[ zurück ]

[ Stichworte ]

[ Die Hyper-Bibliothek ]

[ Systemtheorie ]

[ Meine Bücher ]

Prigogine, I.: Was ist Entropie? (DeepL von What Is Entropy?)

Facultät der Wissenschaften (CP 231), Universität Libre de Bruxelles, B- 1050 Bruxelles und Zentrum für Studien in statistischer Mechanik und Thermodynamik (RLM-7), The University of Texas at Austin, Austin, Texas, 78712 USA

Was ist Entropie?

Die Grundlagen der Entropie und ihre Bedeutung für die thermodynamische Beschreibung der makroskopischen Welt werden im Rahmen der modernen Theorie der Nicht-Gleichgewichtssysteme diskutiert. Die Entropieproduktion in offenen Systemen als Quelle für die Bildung "dissipativer" räumlich-zeitlicher Strukturen ist ein grundlegendes Prinzip in der Physik, Chemie, Biologie und verwandten Wissenschaftsbereichen. Der Artikel beschreibt, wie die Entropie mit der Evolution zusammenhängt, die Irreversibilität, Wahrscheinlichkeit und Kohärenz erfordert, um neue geordnete Phänomene hervorzubringen; er untersucht auch die Rolle der Entropie im Zusammenhang mit den jüngsten kosmologischen Modellen.

Einleitung

Ich möchte den Veranstaltern dafür danken, dass sie mir die Gelegenheit geben, meinem Freund Benno Hess zu gratulieren. Wir kennen uns seit etwa 15 Jahren und haben in dieser relativ kurzen Zeit spektakuläre Veränderungen im wissenschaftlichen Weltbild miterlebt, wie z.B. die zunehmende Bedeutung von Nicht-Gleichgewichtsprozessen und die zunehmende "Biologisierung" (wenn ich es wage, dieses schreckliche Wort zu benutzen) der Physik.

Es ist mir eine besondere Ehre, heute hier zu sein und Benno Hess im Namen der Internationalen Solvay-Institute einen Band über die Kunst von Hieronymus Bosch zu überreichen. Ich glaube, dass das, was Kunst und Wissenschaft so nahe zusammenbringt, die Vorstellungskraft ist. Sowohl die wissenschaftliche als auch die künstlerische Vorstellungskraft sind Versuche, eine Welt zu antizipieren, die oft noch gar nicht geboren ist - eine noch mögliche Welt. Ich behaupte nicht, dass das Universum der Nicht-Gleichgewichts-Strukturen, das wir im Werk von Benno Hess vorhersehen, identisch ist mit der von Hieronymus Bosch beschriebenen Welt von Fleisch und Teufel. Ich möchte jedoch sagen, dass beide durch schöpferische Phantasie entstanden sind.

Entropie: ein seltsames Konzept

Für die moderne Wissenschaft sind Zeit und Entropie eng miteinander verbunden [1]. Eddington nannte die Entropie sogar "den Pfeil der Zeit". Nun ist Entropie ein sehr merkwürdiges Konzept, und ohne zu hoffen, dass es hier zu einer vollständigen Beschreibung kommt, möchte ich einige seiner begrifflichen Dimensionen hervorheben.

1 Besondere Anlässe ziehen oft andere bemerkenswerte Ereignisse nach sich. Professor Benno Hess, Direktor des Max-Planck-Instituts für Ernährungsphysiologie in Dortmund und ein Pionier in der Untersuchung komplexer nichtlinearer Phänomene in offenen chemischen und biochemischen Systemen, feierte am 22. Februar 1987 seinen 65. Am darauffolgenden Tag fand in Dortmund ein Vortrag von Professor Ilya Pigogine von der Universität Libre de Bruxelles statt, der 1967 den Nobelpreis für Chemie für seine Beiträge zur Nichtgleichgewichtsthermodynamik, insbesondere zur Theorie dissipativer Strukturen, erhalten hatte. Für dieses Kolloquium, das gemeinsam von der Gesellschaft Deutscher Chemiker, Dortmund, und dem Max-Planck-Institut organisiert wurde, wählte Ilya Prigogine das allgemeine Thema "Entropie". Er gab einen umfassenden Überblick über seine Ideen zu diesem Konzept im Kontext verschiedener Disziplinen, wie Nichtgleichgewichtsphysik und -Chemie, Biologie und Kosmologie. Mit nur geringfügigen Änderungen ist sein Vortrag auf den folgenden Seiten abgedruckt.

Jeder, der Thermodynamik unterrichtet hat, hat das gleiche Unbehagen bei der Beantwortung der Fragen der Schüler verspürt. Dieses Unbehagen ist vielleicht einer der Gründe, warum ich mich so sehr für das Thema interessiert habe. Wir haben oft darüber diskutiert: "Warum überhaupt Thermodynamik unterrichten?" Man könnte argumentieren, dass die klassische Mechanik, die Quantenmechanik und die Relativitätstheorie die gesamte physikalische Welt, wie wir sie kennen, beschreiben. Wenn alles, was wir vor uns haben, in Form von klassischen Trajektorien oder Wellenfunktionen erklärt werden kann, dann gibt es keinen Platz für Entropie. Natürlich könnte man sagen: Entropie ist nützlich für Leute, die Motoren studieren, und Ingenieure sollten Entropie lehren, aber das ist nicht die richtige Antwort für den Physiker. Im Gegenteil, die Entropie wird in weiten Bereichen der Wissenschaft immer wichtiger; sie hat eine tiefere Bedeutung als die, die beispielsweise durch die bloße Behauptung suggeriert wird, sie sei aus irgendeinem obskuren, praktischen Grund nützlich: Sie sagt uns offensichtlich etwas über das Universum um uns herum.

Was ist die Botschaft der Entropie? Zunächst werden wir uns mit der "Entropie um uns herum, der Entropie in der makroskopischen Welt" befassen, dann mit ihren "dynamischen Grundlagen", die Boltzman sein ganzes Leben lang beschäftigten, und schließlich mit dem "kosmologischen Kontext der Entropie", der uns an die ersten Aussagen von Clausius erinnert, nämlich dass die Energie der Welt konstant ist und die Entropie der Welt zunimmt. Wie können wir diese Aussage im heutigen Kontext der modernen Kosmologie verstehen?

Entropie um uns herum, Entropie in der makroskopischen Welt

Der griechische Begriff, der von Clausius verwendet wurde, um den wissenschaftlichen Begriff "Entropie" zu prägen, hat eine evolutive Bedeutung. Wenn wir von Entropie sprechen, stellen wir die Frage: Leben wir in einer evolutionären Welt?

In einer evolutionären Welt müssen mindestens drei Bedingungen erfüllt sein: (1) Die erste ist die Irreversibilität, denn wenn es eine Evolution gibt, müssen Vergangenheit und Zukunft natürlich verschieden sein. (2)

|

Wir müssen das Konzept der Wahrscheinlichkeit einführen. Wenn wir die Bewegung des Mondes beschreiben, gibt es keinen Grund, von der eigentlichen Evolution zu sprechen, da hier jeder Zustand des Systems (sei es in der Zukunft oder in der Vergangenheit) "von Grund auf" berechnet werden kann. Ganz anders verhält es sich bei der Wettervorhersage, denn hier können wir nur probabilistische Aussagen formulieren. (3) Wir brauchen auch einen Mechanismus der Kohärenz, um ein evolutionäres Universum zu erklären, in dem neue, organisierte Phänomene entstehen. Die Irreversibilität hängt mit der Entropie zusammen, und die Entropieentwicklung kann für jedes beliebige System in zwei additive Terme aufgeteilt werden, von denen der eine den Entropieaustausch mit der Umgebung und der andere die interne Entropieproduktion berücksichtigt, wobei letztere bei Systemen mit irreversiblen Prozessen immer positiv ist. Wenn es keinen Entropiefluss gibt (wie es bei isolierten Systemen der Fall ist), kann die Entropie folglich nur wachsen und ein Maximum erreichen. Die Entropieerzeugung ist mit irreversiblen Prozessen verbunden. Während die gesamte Chemie und die gesamte Biologie irreversibel sind, verwendet die klassische Physik Idealisierungen, bei denen man die Reibung unterdrücken kann, wodurch alle Prozesse reversibel werden. Dies ist in der Chemie nicht möglich, was Max Planck sehr betont hat.

|

![bild]()

|

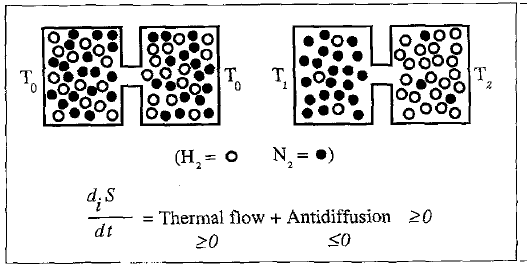

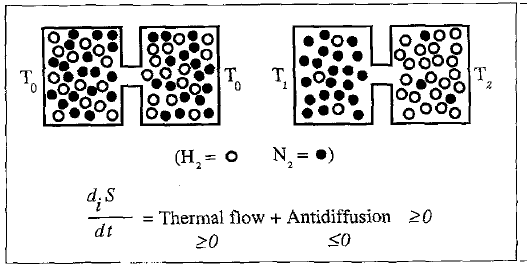

Abb. 1. Thermodiffusionseffekt. Aufgrund der externen thermischen Belastung wird die Verteilung von H 2 und N 2 inhomogen

Abb. 1. Thermodiffusionseffekt. Aufgrund der externen thermischen Belastung wird die Verteilung von H 2 und N 2 inhomogen

|

Welche Rolle spielt die Entropieproduktion? Sie hat oft eine Doppelfunktion: Sie führt nicht notwendigerweise zu Unordnung oder Verschwendung, sondern ist oft ein Mechanismus zur Herstellung von Ordnung. Dies lässt sich an sehr einfachen Beispielen wie der thermischen Diffusion erkennen (Abb. 1). Nehmen wir ein geschlossenes System mit zwei Komponenten, Wasserstoff und Stickstoff. Bei gleichmäßiger Temperatur ist eine gleichmäßige Verteilung von Wasserstoff und Stickstoff gegeben.

|

Wenn man dem System eine thermische Beschränkung auferlegt und einen Temperaturgradienten einführt, wird man einen Konzentrationsgradienten beobachten. In diesem Fall hat die Entropieproduktion eine doppelte Wirkung: Sie ist mit einem Wärmefluss verbunden, der Unordnung erzeugt, aber sie ist auch mit "Antidiffusion" verbunden, die Ordnung bedeutet, da sie eine teilweise Trennung von Wasserstoff und Stickstoff bewirkt. Dieser doppelte Effekt kann in vielen Situationen beobachtet werden. In der Biologie ist die Produktion eines DNA-Moleküls mit der Zerstörung anderer Moleküle verbunden. In der Kosmologie finden wir eine ähnliche Situation vor, denn unser Universum scheint eine duale Struktur aufzuweisen, die einem großen Überschuss an Photonen gegenüber Baryonen entspricht (etwa 109 Photonen für ein Baryon). Photonen scheinen "Abfallprodukte" zu sein, während Baryonen "Fossilien" sind, Objekte, die nicht im Gleichgewicht sind.

Kurz gesagt, es ist nicht wahr, dass Struktur entgegen dem Gesetz der Entropiezunahme erzeugt wird. Im Gegenteil, dieses Gesetz ist wahrscheinlich das grundlegende Gesetz, das für die Existenz des Lebens und des Universums verantwortlich ist. Die Nutzung der Irreversibilität zur Erzeugung von Struktur ähnelt sehr den Prozessen, die wir in einer Stadt beobachten. Dort gibt es zwar eine gewisse unvermeidliche Verschmutzung, aber das ist nur ein Aspekt. Der andere Aspekt ist, dass es Universitäten, Vorlesungen, kulturelle Veranstaltungen, Geburtstagsfeiern usw. gibt. Diese beiden Dinge sind miteinander verbunden. Man kann das eine nicht haben, ohne das andere auch zu haben. Oft sehen wir den Staub oder den Abfall nicht, wir sehen nur die Struktur, und dann sagen wir: Das muss gegen die Gesetze der Thermodynamik sein.

|

![bild]()

|

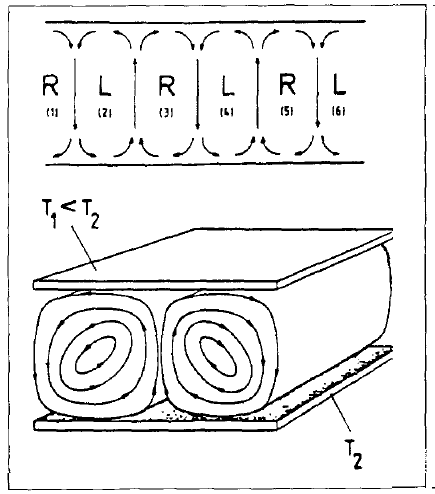

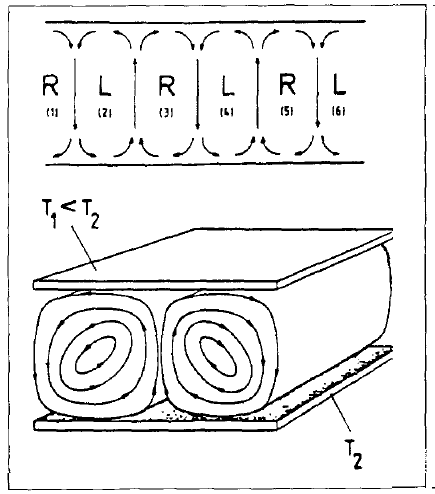

Abb. 2. Instauration von Konvektionswalzen: die Rayleigh-Benard-Instabilität

Abb. 2. Instauration von Konvektionswalzen: die Rayleigh-Benard-Instabilität

|

|

Dies lässt sich am Beispiel der Benard-Instabilität veranschaulichen (Abb. 2). Einer Flüssigkeitsschicht zwischen zwei horizontalen Platten wird von unten ein Wärmestrom aufgezwungen. Irgendwann, bei einem ausreichenden Temperaturgefälle, setzt eine kohärente Bewegung ein. Die Kohärenz ist eines der drei gerade erwähnten Merkmale; sie impliziert, dass Millionen von Molekülen einander "folgen". Dieser stationäre Nichtgleichgewichtszustand, der durch die Kopplung von Schwerkraft und Wärmestrom erzeugt wird, entspricht in der Tat der Entstehung von Kohärenz. Dies ist sehr unerwartet, denn in der klassischen Physik wird Ordnung mit Gleichgewicht assoziiert (wie im Fall von Kristallen), während Unordnung mit Nicht-Gleichgewicht assoziiert wird (wie im Fall von Turbulenz).

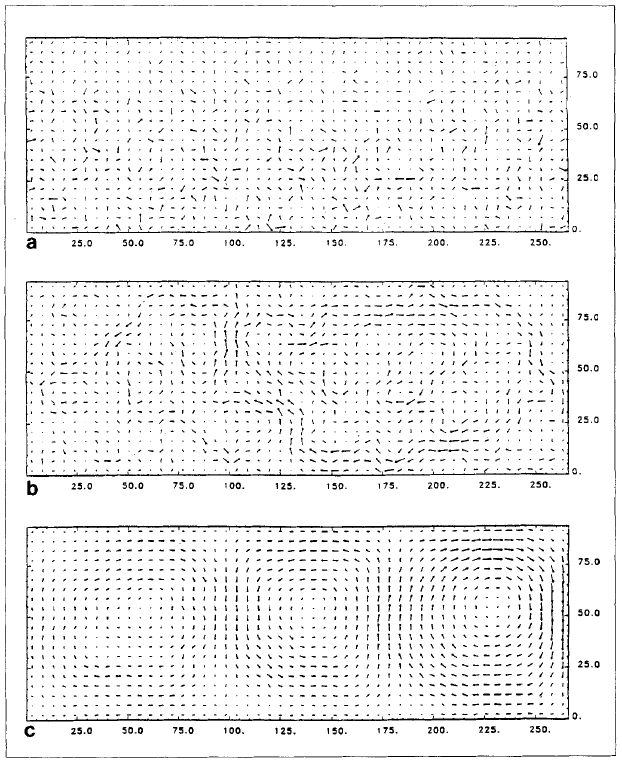

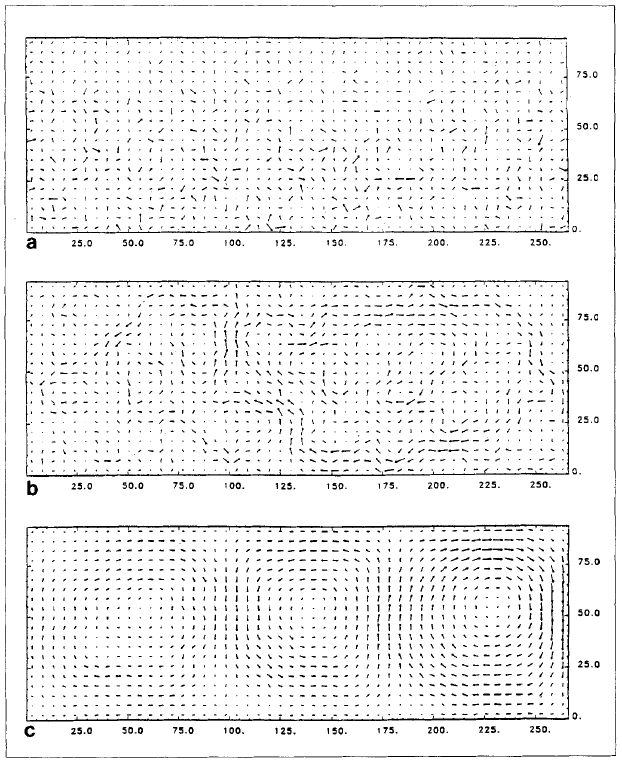

In den letzten Jahren hat sich die Simulation von Nichtgleichgewichtsflüssigkeiten dank der enormen Steigerung der Rechenleistung von "Supercomputern" weiterentwickelt, und die jüngsten Arbeiten von Mareschal und Kestemont [2] zur Molekulardynamik im Nichtgleichgewicht haben einige wirklich beeindruckende Ergebnisse erzielt (Abb. 3). Die folgende Simulation einer hydrodynamischen Instabilität, die sich auf die Benard-Instabilität bezieht, besteht aus einer Anordnung von 5400 Festplatten, die in einem Rechteck eingeschlossen sind; die vertikalen Seiten sind reflektierende Grenzen, während die horizontalen Seiten thermische Reservoirs sind. Eine äußere Kraft (ähnlich der Gravitation) wirkt auf die Partikel des Fluids nach unten, und die Temperatur des unteren Reservoirs ist höher als die des oberen Reservoirs.

Das Verhalten dieser Modellflüssigkeit wird auf einem Computer über die Zeit integriert. Abbildung 3 zeigt ein typisches Geschwindigkeitsfeld, das durch die Wechselwirkung von Wärme und Gravitation erzeugt wird: Jeder Pfeil des Diagramms ist ein Mittelwert der Geschwindigkeiten der Teilchen, die zu einer Zelle gehören (typischerweise 5 pro Zelle); die Berechnung führt auch einen Mittelwert von mehr als zehn Millionen Kollisionen zwischen den Teilchen durch (dies entspricht einem Zeitintervall von 1000 ps). Es ist recht bemerkenswert, dass ein relativ kleines System ein Verhalten zeigt, das sich mit den Begriffen der makroskopischen Hydrodynamik verstehen lässt. Die Nichtgleichgewichtsbedingungen induzieren Korrelationen mit großer Reichweite, die zur Strukturbildung führen.

|

![bild]()

|

Abb. 3. Endliches zweidimensionales System von 5400 Festplatten unter dem Einfluss eines thermischen Gradienten und einer äußeren Kraft (Gravitation). Die Abbildungen zeigen ein typisches Geschwindigkeitsfeld: jeder Pfeil des Graphen ist ein Mittelwert über eine Zelle der Geschwindigkeiten der Teilchen, die zu der Zelle gehören (typischerweise 5 pro Zelle), a) anfängliche (zufällige) mittlere Geschwindigkeitsdichten, c) dieselben mittleren Dichten nach einigen Tausend Kollisionen; jetzt sind Wirbel zu erkennen, die regelmäßigen Teilchenströmen entsprechen, b) dasselbe System unter verschiedenen äußeren Bedingungen; während Wirbelpools tatsächlich vorhanden zu sein scheinen, gibt es keine stabilen, geordneten StrukturenAbb. 3. Endliches zweidimensionales System von 5400 Festplatten unter dem Einfluss eines thermischen Gradienten und einer äußeren Kraft (Gravitation). Die Abbildungen zeigen ein typisches Geschwindigkeitsfeld: jeder Pfeil des Graphen ist ein Mittelwert über eine Zelle der Geschwindigkeiten der Teilchen, die zu der Zelle gehören (typischerweise 5 pro Zelle), a) anfängliche (zufällige) mittlere Geschwindigkeitsdichten, c) dieselben mittleren Dichten nach einigen Tausend Kollisionen; jetzt sind Wirbel zu erkennen, die regelmäßigen Teilchenströmen entsprechen, b) dasselbe System unter verschiedenen äußeren Bedingungen; während Wirbelpools tatsächlich vorhanden zu sein scheinen, gibt es keine stabilen, geordneten Strukturen

Abb. 3. Endliches zweidimensionales System von 5400 Festplatten unter dem Einfluss eines thermischen Gradienten und einer äußeren Kraft (Gravitation). Die Abbildungen zeigen ein typisches Geschwindigkeitsfeld: jeder Pfeil des Graphen ist ein Mittelwert über eine Zelle der Geschwindigkeiten der Teilchen, die zu der Zelle gehören (typischerweise 5 pro Zelle), a) anfängliche (zufällige) mittlere Geschwindigkeitsdichten, c) dieselben mittleren Dichten nach einigen Tausend Kollisionen; jetzt sind Wirbel zu erkennen, die regelmäßigen Teilchenströmen entsprechen, b) dasselbe System unter verschiedenen äußeren Bedingungen; während Wirbelpools tatsächlich vorhanden zu sein scheinen, gibt es keine stabilen, geordneten StrukturenAbb. 3. Endliches zweidimensionales System von 5400 Festplatten unter dem Einfluss eines thermischen Gradienten und einer äußeren Kraft (Gravitation). Die Abbildungen zeigen ein typisches Geschwindigkeitsfeld: jeder Pfeil des Graphen ist ein Mittelwert über eine Zelle der Geschwindigkeiten der Teilchen, die zu der Zelle gehören (typischerweise 5 pro Zelle), a) anfängliche (zufällige) mittlere Geschwindigkeitsdichten, c) dieselben mittleren Dichten nach einigen Tausend Kollisionen; jetzt sind Wirbel zu erkennen, die regelmäßigen Teilchenströmen entsprechen, b) dasselbe System unter verschiedenen äußeren Bedingungen; während Wirbelpools tatsächlich vorhanden zu sein scheinen, gibt es keine stabilen, geordneten Strukturen

|

|

Ein interessanter Punkt, der sich aus diesen neuen Simulationen ergibt, ist die Tatsache, dass es selbst im Gleichgewicht einen Pfeil der Zeit gibt. Während die Moleküle vor der Kollision im Gleichgewicht unkorreliert sind, entstehen durch die Kollision Korrelationen, die dann abklingen. Dies ist nicht so erstaunlich. Der Mechanismus der Kollision bleibt nämlich derselbe, und schließlich wissen die kollidierenden Moleküle nicht, ob das System, zu dem sie gehören, im Gleichgewicht ist oder nicht. Der Zeitpfeil, den wir selbst in einem Gleichgewichtssystem sehen, ist ziemlich unerwartet, denn er scheint eine Verletzung der Mikroreversibilität zu implizieren. Es handelt sich um eine privilegierte Zeitrichtung, die der Sequenz [ Kollisionen -> Korrelationen ] und nicht der Sequenz [ Korrelationen -> Kollisionen ] entspricht. Das ist nicht trivial, denn bei einem Zweikörpersystem in einem endlichen Behälter wäre das nicht der Fall.

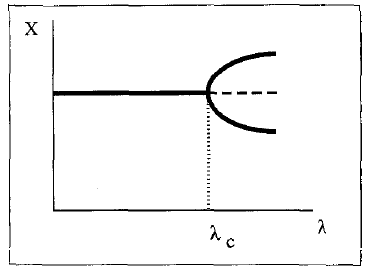

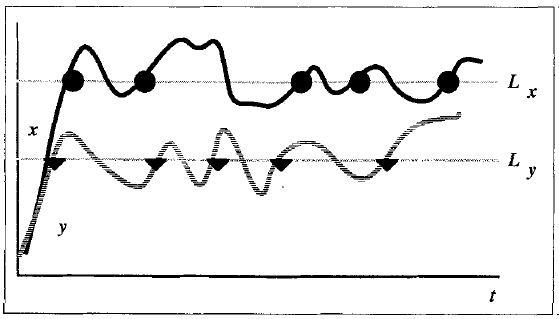

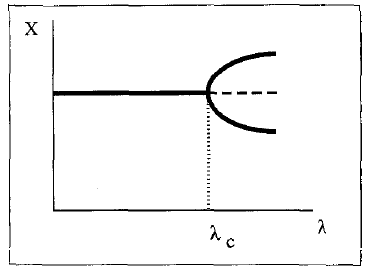

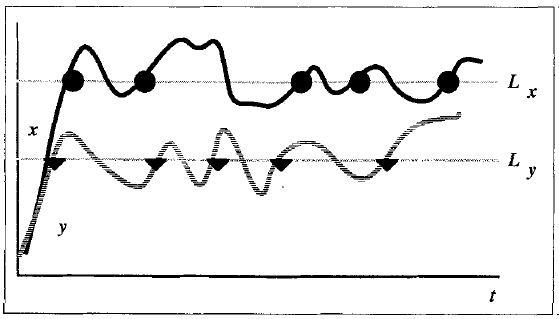

Ein weiterer Aspekt, den ich hervorheben möchte, ist die Wahrscheinlichkeit. Dieser Aspekt wird sehr deutlich, wenn man sich mit Bifurkationen befasst. Weit vom Gleichgewicht entfernt, treten Systeme in den nichtlinearen Bereich ein und zeigen eine Vielzahl von Lösungen für die Gleichungen, die ihre Entwicklung beschreiben. An Bifurkationspunkten ist die Rolle der Fluktuationen insofern entscheidend, als wir auf der Grundlage der deterministischen Gleichungen nicht vorhersagen können, welchem Zweig das Verhalten des Systems folgen wird (Abb. 4).

|

![bild]()

|

Abb. 4. Bifurkation. Für einen bestimmten Wert des Kontrollparameters k, der mit dem Abstand zum Gleichgewicht bezogen auf den Abstand zum Gleichgewicht, weist das System mehr als einen stabilen Zustand

Abb. 4. Bifurkation. Für einen bestimmten Wert des Kontrollparameters k, der mit dem Abstand zum Gleichgewicht bezogen auf den Abstand zum Gleichgewicht, weist das System mehr als einen stabilen Zustand

|

Dissipative Systeme weisen ein weiteres auffälliges dynamisches Merkmal auf, nämlich dass sie Attraktoren besitzen. Wenn man einem dissipativen System eine Störung auferlegt, kann es zu einer Referenzregion zurückkehren, die als "Attraktor" bezeichnet wird und verschiedene Komplexitätsstufen haben kann, da das System zu einem festen Punkt oder zu einer Linie (wie der Grenzzyklus, z. B. bei chemischen Uhren) oder zu einem komplexeren Objekt getrieben werden kann, wie im Fall der "seltsamen" Attraktoren. Letztere werden durch Punktmengen gebildet, die eine fraktale (nicht ganzzahlige) Dimension haben, die wir hier nicht zu definieren versuchen. In diesem letzten Fall reagiert das Verhalten des Systems sehr empfindlich auf die Anfangsbedingungen und zeigt Sprünge von einer Region zur anderen.

Das Studium von Attraktoren ist derzeit ein sehr aktives Forschungsgebiet, zumal man interessante Probleme durch entsprechende Attraktoren beschreiben kann. Lassen Sie mich ein paar Probleme nennen, die auf diese Weise beschrieben wurden. Im Fall der langfristigen klimatischen Veränderungen [3] entspricht die Dimension des Attraktors etwa 3,1, was in der Tat eine kleine Zahl ist, wenn man an die unglaubliche Komplexität des Problems denkt. Bei der dynamischen Charakterisierung neurologischen Verhaltens wurden kürzlich einige verblüffende Ergebnisse durch die Erstellung von Phasenporträts aus elektroenzephalographischen (EEG) Aufzeichnungen menschlicher Probanden erzielt [4]. Das zeitliche Verhalten solcher Signale ist eindeutig mit Attraktoren verbunden, deren Dimension nicht ganzzahlig zu sein scheint, was für chaotische Dynamik charakteristisch ist. Es konnte gezeigt werden, dass verschiedenen Schlafniveaus bei menschlichen Probanden unterschiedliche Werte der (nicht ganzzahligen) Dimensionalität entsprechen. Zum Beispiel beträgt die D2-Korrelationsdimension von Grassberger-Procaccia etwa 9,7 (+_0,7) für eine wache Person mit offenen Augen, 8,2 (+_0,4) für den REM-Schlaf und 4,4 (+_0,4) für den Tiefschlaf. Interessanterweise sinkt der Wert bei Epilepsie auf etwa 2. Eine der Krankheiten des Gehirns entsteht also durch zu viel Kohärenz, nicht durch zu wenig.

|

Wir sehen, dass die moderne Wissenschaft neue Werkzeuge für die Beschreibung des Verhaltens dynamischer Systeme gefunden hat. Aber welche besondere Rolle spielt die Chemie im Vergleich zu anderen Bereichen, die Nicht-Gleichgewichtsstrukturen untersuchen? Ich denke, die Chemie ermöglicht es uns zu sehen, wie Zeit in Materie eingekapselt werden kann. Dies ist von besonderer Bedeutung, da wir in der Lage sein sollten, eine Welt zu beschreiben, in der die bloße Existenz biologischer Systeme eine gewisse Aufzeichnung von Zeitphänomenen in der Materie impliziert. Die Hydrodynamik kann diesen Effekt nicht zeigen. Wenn man zum Beispiel den Wärmefluss in der B6nard-Instabilität stoppt, verschwindet die erzeugte Struktur sofort. Im Gegenteil, wenn man eine chemische Reaktion durchführt, kann man Moleküle erhalten, die eine gewisse Erinnerung an die Nicht-Gleichgewichtsbedingungen ihrer Entstehung bewahren. Dies ist ein Effekt, der nicht genug hervorgehoben wurde.

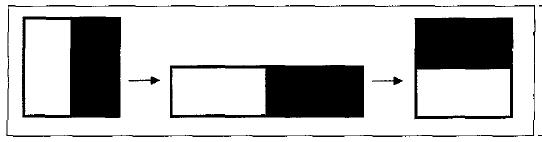

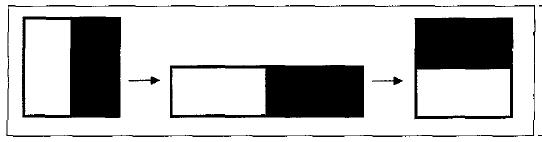

Um dies an einem sehr einfachen Beispiel zu verdeutlichen, nehmen wir zwei Monomere, X und Y, die sich gegenseitig ineinander umwandeln oder ein Polymer bilden können (Abb. 5). Jedes Mal, wenn die Konzentration eines der beiden Monomere über einem kritischen Wert liegt, wird es Teil der Polymerkette. Wenn wir dieses Polymer unter nahezu gleichgewichtigen Bedingungen herstellen, bei denen die Konzentrationen gemäß dem Poisson-Gesetz heftig fluktuieren, erhalten wir eine hochgradig ungeordnete Kette ohne Kohärenz, wie z. B. XXYXYYYYXYYYYXXXYX... Wenn das Verhalten des Systems einem Grenzzyklus entspricht, würde die Kette natürlich in etwa so aussehen wie XYXYXYXYXY... Hier sehen wir bereits, dass das Nicht-Gleichgewicht in die Struktur des Polymers "eingekapselt" wurde.

|

![bild]()

|

Abb. 5. Chaotische Reaktion in Verbindung mit einem Polymer-String durch "Kodierung". Schwellenwerte für zwei Variablen X und Y. Erstellter String: YXXYYYYXXYX ....

Abb. 5. Chaotische Reaktion in Verbindung mit einem Polymer-String durch "Kodierung". Schwellenwerte für zwei Variablen X und Y. Erstellter String: YXXYYYYXXYX ....

|

Dies vorausgeschickt, ist eine periodische Struktur wie XYXYXY... kein sehr hoffnungsvoller Kandidat für die Erzeugung von Biomolekülen. Deshalb finde ich die jüngste Arbeit von Nicolis und G. und J. Subba Rao sehr interessant, in der die polymererzeugende Reaktion mit einer chaotischen Reaktion gekoppelt ist [5]. Es entsteht eine Kette, die in gewisser Weise "zwischen" den geordneten und den ungeordneten Strukturen liegt, und die Abfolge von X und Y kann durch eine Markov-Kette höherer Ordnung beschrieben werden. Solche Strukturen haben einen gewissen "Informationsgehalt", der einer "inkompressiblen" eindimensionalen Information entspricht. Eines der Probleme der Informationstheorie besteht darin, dass man, um den Informationsgehalt einer Nachricht zu messen, angeben muss, wie lang das Programm sein muss, das diese Nachricht erzeugen kann. Offensichtlich ist das Programm, das in der Kette XYXYXY... übersetzt wird, sehr kurz. Wenn die Kette jedoch einige weitreichende Korrelationen enthält, braucht man ein viel längeres Programm, um sie zu erzeugen; dieser Fall ist realistischer.

Wir stehen hier vor dem Problem, die Chemie mit der Informationstheorie in Verbindung zu bringen, ein Problem, das in der Arbeit von Manfred Eigen wunderbar veranschaulicht wird. Es bleibt noch viel zu tun, aber es ist klar, dass das Leben mit Nicht-Gleichgewichtssituationen zusammenhängt, die wahrscheinlich irgendwann seltsame Attraktoren nutzen, um Informationen zu erzeugen. Daher kann man sagen, dass das Leben mit Instabilität verbunden ist. Wir werden sehen, dass die gegenwärtige Situation in der Kosmologie ganz ähnlich ist.

Dynamische Grundlagen der Entropie

Wenn ich einen Würfel oder eine Münze werfe, werde ich eine gewisse Regelmäßigkeit in der Verteilung des Ergebnisses feststellen, nämlich V2 vs. 1/2 für den Fall des Münzwurfs. Welches ist das Grundgesetz der Natur, das sich im Münzwurf ausdrückt? Man könnte sagen: Wahrscheinlichkeit; aber diese Antwort mag seltsam klingen, denn wir wissen ja, dass die Münze den Newtonschen, deterministischen Gesetzen unterworfen ist. Die moderne Dynamik gibt eine sehr schöne Antwort auf dieses Dilemma: Um festzustellen, ob die Gesetze, die in diesem System herrschen, probabilistisch oder deterministisch sind, müssen wir uns die Vorbereitung des Systems ansehen.

Nehmen wir an, wir nehmen nacheinander immer besser bekannte Ausgangsbedingungen an. Dann können zwei Dinge passieren: Entweder kann ich bei einem gegebenen Präzisionsniveau sagen, dass für einige endliche Intervalle von Anfangsbedingungen alle Ergebnisse "plus" sein werden und für einige andere Intervalle "minus", in diesem Fall ist das System an sich vorhersehbar, und unsere probabilistische Beschreibung war nur auf unsere unzureichende Kenntnis der Anfangsbedingungen zurückzuführen. Oder jeder Punkt, der zu einem "Plus"-Ergebnis führt, ist von Punkten umgeben, die zu einem "Minus" führen, so wie bei den reellen Zahlen jeder rationale Punkt von einem irrationalen umgeben ist und umgekehrt. In diesem letzteren Fall kann ich mit keiner noch so hohen Präzision eine deterministische Vorhersage des Ergebnisses treffen, denn alles, was ich weiß, ist ein endliches Intervall, und ein endliches Intervall entspricht einer unendlichen Anzahl von Punkten. Das Kuriose daran ist, dass diese Situation für eine große Klasse von dynamischen Systemen gilt, bei denen die Empfindlichkeit gegenüber den Anfangsbedingungen so groß ist, dass wir das Endergebnis nicht mit Sicherheit vorhersagen können, unabhängig von der (endlichen) Genauigkeit unserer Informationen [6].

|

Dieser Punkt wird gut durch die so genannte "Baker-Transformation" veranschaulicht, die auf ein Quadrat angewandt wird, das die einfache Operationsfolge: Abflachen, Schneiden, Falten darstellt. Infolgedessen werden zwei beliebige Ausgangspunkte, unabhängig davon, wie nahe sie beieinander liegen, früher oder später aufgrund der Iteration dieser Transformation auseinanderlaufen (Abb. 6). Diese Divergenz lässt sich sehr elegant darstellen, indem man binäre Ziffern für die Koordinaten der Punkte im Phasenraum verwendet; jede Iteration entspricht dann einer "Bernoulli"-Verschiebung zwischen diesen Ziffern. Dies bedeutet, dass wir eine exponentiell ansteigende Genauigkeit der Anfangsbedingungen benötigen, um ein bestimmtes Maß an Präzision in unseren Vorhersagen über linear ansteigende Zeitintervalle zu gewährleisten.

|

![bild]()

|

Fig. 6. Baker transformation

Fig. 6. Baker transformation

|

Jede endliche Beobachtung kann jedoch nur eine endliche Anzahl von Ziffern liefern, wie auch immer diese aussehen mag. Die Situation ist ähnlich wie in der Meteorologie. Es ist unmöglich, das Wetter über große Zeiträume vorherzusagen, da die klimatische Entwicklung einem sehr instabilen dynamischen System zu entsprechen scheint, in dem zwei beliebige Anfangsbedingungen, egal wie nahe sie beieinander liegen, mit der Zeit exponentiell divergieren, weshalb wir nur probabilistische Vorhersagen machen können.

Dieser Übergang von der Instabilität zur Wahrscheinlichkeit führt auch zur Irreversibilität, die das Hauptproblem war, das Boltzmann untersuchte. Leider war die Zeit für ihn noch nicht reif für die Untersuchung instabiler dynamischer Systeme, sondern die dynamische Beschreibung beschränkte sich im Wesentlichen auf so genannte integrierbare Systeme wie das Pendel oder die ungestörte Newtonsche Planetenbewegung, die einer vollständigen Beschreibung und somit vollständig deterministischen Vorhersagen zugänglich sind. Für Boltzmann konnte die Irreversibilität nur auf einige sehr spezielle Anfangsbedingungen zurückzuführen sein. In dem neuen Kontext ergibt sich die Irreversibilität aus einer Einschränkung der Messbarkeit. Ich möchte diesen Punkt hervorheben, weil er auch in der Relativitätstheorie, in der Quantenmechanik und in der Thermodynamik zu finden ist; er ist wirklich eines der Leitmotive unseres Jahrhunderts.

Um den konzeptionellen Wandel zu messen, der sich im Kern der "klassischen" Physik vollzogen hat, zitiere ich einen kürzlich erschienenen Aufsatz von J. Lighthill mit dem Titel The Recently Recognized Failure of Predictability of Newtonian Dynamics Dynamics[7]: "Ich muss im Namen der breiten weltweiten Bruderschaft der Praktiker der Mechanik sprechen. Wir möchten uns kollektiv dafür entschuldigen, dass wir die gebildete Öffentlichkeit in die Irre geführt haben, indem wir Vorstellungen über den Determinismus von Systemen, die den Newtonschen Bewegungsgesetzen genügen, verbreitet haben, die sich nach 1960 als falsch erwiesen haben".

Die Grundaussage der Entropie ist also, dass wir in einer Welt leben, die von instabilen dynamischen Systemen geprägt ist. Bestünde unser Universum nur aus regelmäßigen, zeitlich reversiblen Bewegungen wie dem Planetenmodell oder dem harmonischen Oszillator, wäre kein Platz für Entropie, für Chemie oder für Biologie. Entropie war ein seltsames Objekt, da man lehrte, dass der Prototyp dynamischer Systeme integrierbare Systeme sind. In der Tat gibt es für integrierbare Systeme keine Entropie, und die Studenten, die fragten: "Warum Entropie?", hatten Recht. In dem neuen Kontext muss die Untersuchung der Entropie auf drei Ebenen erfolgen. Da ist zunächst die phänomenologische Ebene, die in der thermodynamischen Beschreibung enthalten ist. Hier ist das wichtigste neue Element die konstruktive Rolle der irreversiblen Prozesse. Die zweite Ebene entspricht der Einbettung der Irreversibilität in die klassische Dynamik. Auf dieser Ebene vertrauen wir immer noch auf die klassische Dynamik, aber wir müssen zeigen, wie Instabilität zu einer Beschreibung führt, die Irreversibilität einschließt. Auch wenn noch einige Fortschritte erzielt werden müssen, ist diese zweite Ebene inzwischen vergleichsweise gut verstanden. Aber es gibt noch eine dritte Ebene: Die klassische Dynamik ist ja nicht der konzeptionelle Rahmen des 20. Jahrhunderts, sondern die grundlegenden Theorien sind heute die Quantentheorie und die allgemeine Relativitätstheorie. Es ist bemerkenswert, dass diese beiden Theorien einer zeitlich reversiblen Beschreibung entsprechen, und dass beide modifiziert werden müssen, um den zweiten Hauptsatz der Thermodynamik zu berücksichtigen. Es würde den Rahmen dieser Vorlesung sprengen, die Probleme der Quantenmechanik und ihre mögliche Neuformulierung als eine mögliche Folge der jüngsten Fortschritte in unserem Verständnis der klassischen Mechanik zu behandeln.

Kosmologischer Kontext der Entropie

Wie entstand die Zeit, wie entstand die Entropie? Man erinnere sich an die klassische Aussage von Clausius: die Energie des Universums ist konstant, die Entropie des Universums nimmt zu. Welche Bedeutung haben solche Aussagen heute?

In vielen Texten kann man heute lesen, dass unser Universum ein "kostenloses Mittagessen" ist. Dieser Vorschlag, der auf Pascual Jordan zurückgeht, bedeutet Folgendes: Die Energie tritt in zwei Formen auf, der Gravitation und der Materie. Die Gravitation entspricht einer anziehenden Kraft, also einer negativen Energie (das ist nicht einfach, wenn man etwas tiefer schaut); die Materie entspricht einer positiven Energie. Im Vakuum gäbe es weder Gravitation noch Materie; metaphorisch ausgedrückt: 0 = 0 + 0.

Im Gegensatz dazu haben wir in der realen Welt eine Summe aus zwei Größen, einer positiven und einer negativen, die sich wiederum zu Null summieren können. Dies ist die Idee des "kostenlosen Mittagessens". Erinnern Sie sich an die hydrodynamische Instabilität der Benard-Zellen. Der Preis für diese Zellen oder der Preis für die DNA ist nicht die Energie; aus dieser Sicht sind die DNA oder die Benard-Zellen ein kostenloses Mittagessen. Der Preis ist die Entropie! Wenn wir das System von unten beheizen, geht der größte Teil des Wärmestroms verloren, aber ein Teil davon wird zur Erzeugung des Musters verwendet. Der Unterschied zwischen Sein und Nichtsein (Sein oder Nichtsein) ist also nicht die Energie, sondern die Entropie. Der Preis für das Universum ist in Entropie zu zahlen.

Wie wurde dieser Preis am Anfang unseres Universums gezahlt? Die klassische Vorstellung war, dass die Entropie mit der Zeit zunimmt; jeden Tag kommen wir dem Wärmetod näher. Aber das kann nicht die ganze Geschichte sein. Die derzeitige "Gesamtentropie" des Universums wird anhand der Gesamtzahl der Photonen geschätzt, während die so genannte "spezifische Entropie" des Universums anhand der Anzahl der Photonen pro Baryon gemessen wird, die etwa 109 beträgt. Diese beiden Zahlen führen uns zurück zum ersten Stadium des Universums. Die Entropie des heutigen Universums wurde zu Beginn des Universums erzeugt. Mit anderen Worten, das Universum begann mit einem Entropieschub, der "Hitzetod" liegt hinter uns, nicht vor uns, und die gegenwärtige Zunahme der Entropie aufgrund der irreversiblen Prozesse, die noch in der Biosphäre oder in den Sternen ablaufen, ist vernachlässigbar im Vergleich zu der Entropieproduktion, mit der unser Universum begann.

Wir erinnern uns, dass die moderne Kosmologie auf der allgemeinen Relativitätstheorie beruht, die die Raum-Zeit-Struktur mit der Materie verbindet, die in Form von Druck und Dichte dargestellt wird. Die Geschichte der Kosmologie veranschaulicht sehr schön die zunehmende Rolle der Zeit in der Wissenschaft. Die erste Idee Einsteins aus dem Jahr 1917, ein statisches Universum zu beschreiben, hat nur wenige Jahre überdauert, weil sich bald herausstellte, dass Einsteins statische Lösung instabil war; dann kam eine weitere Entdeckung: die Expansion des Universums. Und noch später kam die große Überraschung (1965): Das Universum enthält eine "restliche" Schwarzkörperstrahlung.

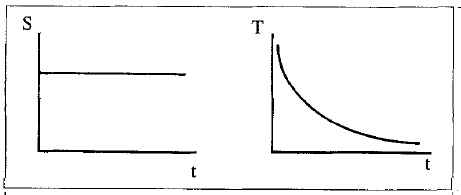

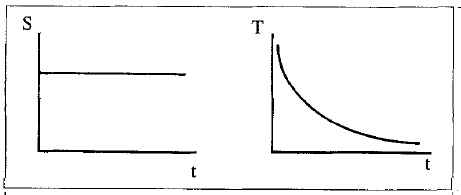

|

So ging die wissenschaftliche Gemeinschaft von einem statischen Universum zu einem historischen Universum über, das einer zeitabhängigen Geometrie entspricht, und schließlich zu einem Modell, das eine intrinsische Evolution beinhaltet. Das in den 1970er Jahren entwickelte "Standardmodell" (Abb. 7) besagt, dass die Temperatur zunimmt, wenn wir uns dem Ursprung des so genannten Urknalls nähern. Die Entropie ist nach den Einsteinschen Gleichungen eine Konstante, da diese Gleichungen eine adiabatische Entwicklung beschreiben. Das ist natürlich, denn die allgemeine Relativitätstheorie ist in erster Linie eine Verallgemeinerung der Newton'schen Himmelsdynamik, und im Falle der Planetenbewegung gibt es offensichtlich keine Entropieproduktion. Dies ist nicht sehr befriedigend, und in den letzten Jahren wurden immer mehr Anstrengungen unternommen, die Anfangsbedingungen zu verstehen. Eine Anfangsbedingung, bei der das Universum mit einer enormen Entropie und einer Temperatur in der Größenordnung von 1032 (der "Planck-Temperatur") beginnt, ist ein seltsamer Ausgangspunkt. Eine Theorie, die für bestimmte Aspekte erfolgreich war, ist das "Inflationsmodell", das hier nicht weiter beschrieben werden soll, da es das Problem der Irreversibilität, an dem wir hier interessiert sind, nicht behandelt.

|

![bild]()

|

Abb. 7. Kosmologisches Standardmodell: Die Temperatur nimmt mit der Zeit ab, während die Entropie konstant bleibt

Abb. 7. Kosmologisches Standardmodell: Die Temperatur nimmt mit der Zeit ab, während die Entropie konstant bleibt

|

Das von meinen Kollegen und mir entwickelte Modell [9] basiert auf der Idee der Instabilität des Minkowski-Vakuums, die von Brout, Englert und Gunzig eingeführt wurde. Das Vakuum (man erinnere sich an die Idee des kostenlosen Mittagessens) ist in gewisser Weise mit einer unterkühlten Flüssigkeit vergleichbar. Wenn in einer unterkühlten Flüssigkeit ein Kristallkern entsteht, der groß genug ist, wird er zu einem Festkörper. Unser Ansatz legt nahe, dass die Situation in gewisser Weise ähnlich ist, wenn man eine Kopplung zwischen Gravitation und einem skalaren Materiefeld annimmt. Im Vakuum gibt es Fluktuationen, die dem Auftreten von massiven Teilchen entsprechen (wie in der unterkühlten Flüssigkeit), und es gibt eine kritische Masse, die 50 Planck-Massen entspricht. Wenn die fluktuierenden massiven Teilchen das Niveau der kritischen Masse erreichen, wird das Vakuum kritisch, und das System tritt in eine neue Phase ein, die einem Universum und nicht mehr dem Vakuum entspricht. Bei diesem Ansatz gibt es keinen Urknall mehr, sondern eine Art Phasenübergang, der von einem Vorläufer des Universums (dem "Vakuum") zu einem frühen Stadium des Universums führt (für weitere Einzelheiten siehe [9]).

Eine Planck-Masse entspricht 10-5 g, was im Vergleich zu einem Elementarteilchen riesig ist und nur ein Schwarzes Loch sein kann, denn die Compton-Wellenlänge dieser Masse ist etwa 1020-mal kleiner als ihr Schwarzschild-Radius, und wenn die Größe eines gegebenen Körpers der Masse m kleiner ist als sein Schwarzschild-Radius, dann können weder Materie noch Strahlung aus diesem Körper entweichen.

Das neue Szenario, das für die Entstehung unseres Universums vorgeschlagen wird, sieht folgendermaßen aus. Die Instabilität führt zu einer Population von schwarzen Löchern. In diesem Stadium haben wir ein "de Sitter"-Universum, das einer konstanten Dichte der Population schwarzer Löcher entspricht, und ein exponentiell wachsendes Universum. Schwarze Löcher haben jedoch eine endliche Lebenszeit. Sie verdampfen nach einer Zeit in der Größenordnung von 10-37 s. In diesem Moment verwandelt sich das "de Sitter"-Universum in das übliche, sich adiabatisch entwickelnde "Friedman-Lemaitre"-Universum.

|

So ging die wissenschaftliche Gemeinschaft von einem statischen Universum zu einem historischen Universum über, das einer zeitabhängigen Geometrie entspricht, und schließlich zu einem Modell, das eine intrinsische Evolution beinhaltet. Das in den 1970er Jahren entwickelte "Standardmodell" (Abb. 7) besagt, dass die Temperatur zunimmt, wenn wir uns dem Ursprung des so genannten Urknalls nähern. Die Entropie ist nach den Einsteinschen Gleichungen eine Konstante, da diese Gleichungen eine adiabatische Entwicklung beschreiben. Das ist natürlich, denn die allgemeine Relativitätstheorie ist in erster Linie eine Verallgemeinerung der Newton'schen Himmelsdynamik, und im Falle der Planetenbewegung gibt es offensichtlich keine Entropieproduktion. Dies ist nicht sehr befriedigend, und in den letzten Jahren wurden immer mehr Anstrengungen unternommen, die Anfangsbedingungen zu verstehen. Eine Anfangsbedingung, bei der das Universum mit einer enormen Entropie und einer Temperatur in der Größenordnung von 1032 (der "Planck-Temperatur") beginnt, ist ein seltsamer Ausgangspunkt. Eine Theorie, die für bestimmte Aspekte erfolgreich war, ist das "Inflationsmodell", das hier nicht weiter beschrieben werden soll, da es das Problem der Irreversibilität, an dem wir hier interessiert sind, nicht behandelt.

|

![bild]()

|

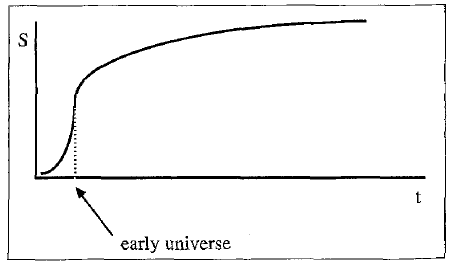

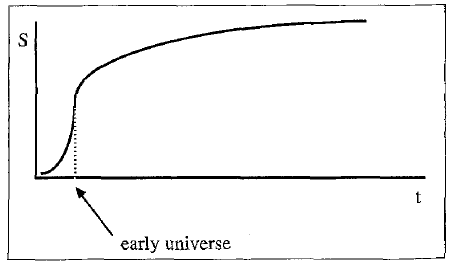

Abb. 8. Entwicklung der Entropie für das hier vorgestellte Modell

Abb. 8. Entwicklung der Entropie für das hier vorgestellte Modell

|

Natürlich enthält ein solches Szenario spekulative Elemente. Interessant ist jedoch, dass wir die richtige Größenordnung für die Gesamtentropie des Universums und für das Verhältnis von Baryonen zu Photonen vorhersagen können. Es scheint also, dass der größte Teil der Entropie des Universums in einer sehr kurzen Zeit in der Größenordnung von 10-37 s entstanden ist (Abb. 8). In dieser neuen Perspektive liegt der "Wärmetod" im Wesentlichen hinter uns, denn dieser anfängliche Anstieg ist im Vergleich zu allem, was später passieren kann, enorm. Dies führt zu der gleichen Situation wie bei der Benard-Instabilität, mit vielen Abfallprodukten und einigen wenigen Nicht-Gleichgewichtsobjekten, die sehr wertvoll sind, weil sie die Moleküle hervorbringen, aus denen das entsteht, was wir Materie und später Leben nennen. So entsteht eine Art Umkehrung des klassischen Bildes in der Kosmologie, das besagt, dass das Universum zu Beginn sehr geordnet ist, die Entropie langsam zunimmt und das Universum schließlich dem Hitzetod ausgesetzt ist. In dem neuen Bild wird der größte Teil der gesamten Entropie in einer sehr kurzen Zeit erzeugt.

Dieses Modell scheint mir recht zufriedenstellend zu sein, weil es zwei Grundtendenzen der modernen Physik vereint. Einerseits sind die Ergebnisse unter dem Gesichtspunkt der starken Vereinheitlichungstendenz, z. B. der Vereinheitlichung der fundamentalen Wechselwirkungen, sehr schön, da wir die Entropie des gegenwärtigen Universums in Form von nur drei fundamentalen Konstanten berechnen können: Plancksche Konstante, Lichtgeschwindigkeit und Gravitation. Andererseits kann ein vereinheitlichtes Bild der Welt nicht die ganze Geschichte sein, denn eine vereinheitlichte Welt wäre eine statische Welt. Selbst wenn die Gleichungen hochgradig nichtlinear sind, hätten sie immer noch statische Lösungen. Wir brauchen also eine treibende Kraft für die Evolution, die in einer dissymmetrischen Beziehung zwischen Raum-Zeit und Materie besteht. Die Raumzeit erzeugt Materie durch einen irreversiblen Prozess. Materie ist eine Verschmutzung, ein Abfallprodukt der Raumzeit.

Aus der Sicht der Energie scheint es keinen wesentlichen Unterschied zwischen Raumzeit und Materie zu geben. Die Raumzeit wird durch Felder beschrieben, und Felder können mit Materie verbunden sein. Der Unterschied liegt in der Entropieerzeugung. Schwarze Löcher, die möglicherweise der Ursprung der heutigen Materie sind, haben nicht nur eine Masse, sondern auch eine Entropie. Der grundlegende Pfeil der Zeit wäre auf den Materiegehalt des Universums zurückzuführen. Schöpfung und Zeit sind von Anfang an miteinander verbunden.

Offensichtlich befinden wir uns hier an den Grenzen der Wissenschaft, und jeden Monat erscheint in der Literatur ein anderes Szenario für die Entstehung des Universums. Wenn das Szenario, das ich hier vorgestellt habe, etwas ernster genommen werden kann, dann deshalb, weil es von Anfang an den zweiten Hauptsatz der Thermodynamik durch die Erschaffung der Materie einbezieht und weil es zu vernünftigen Vorhersagen führt. Wie dem auch sei, in den meisten grundlegenden Forschungsbereichen, sei es in der Biologie, in der Quantentheorie oder in der Kosmologie, sehen wir das Auftauchen neuer Gesichtspunkte, die die Zeit, die Irreversibilität und die Fluktuationen betonen.

Es ist angebracht, diese Geburtstagsrede mit dem Hinweis zu schließen, dass die Wissenschaft dank der Arbeit von Menschen wie Benno Hess nie wieder so sein wird, wie sie es noch vor zwei oder drei Jahrzehnten war.

1. Prigogine, I.: From Being to Becoming. San Francisco: Freeman 1980; Prigogine, I., Stengers, I.: La Nouvelle Alliance. Paris: Gallimard 1979

2. Kestemont, E., Mareschal, M.: J. Stat. Phys. 48, 1187 (1987)

3. Nicolis, G., Nicolis, C.: Natur 311, 529 (1985)

4. Babloyantz, A., Destexhe, A.: Proc. Nat. Acad. Sci. USA 83, 3513 (1987); Proc. first IEEE Conf. on Neural Networks, San Diego 1987

5. Nicolis, G., Subba Rao, G., Subba Rao, J., in: Structure, Coherence and Chaos in Dynamical Systems. Manchester Univ. Press 1987

6. Arnold, V. I., Avez, A.: Ergodic Problems of Classical Mechanics. New York: Benjamin 1968; Misra, B., Prigogine, I., Courbage, M.: Proc. Nat. Acad. Sci. USA 76, 3607 (1979); Elskens, Y., Prigogine, I.: ibid. 83, 5756 (1986)

7. Lighthill, J., in: Predictability in Science and Society, S. 35 (J. Mason et al., eds.). London: Royal Society 1986

8. Prigogine, I., Petrosky, T.: Physica (im Erscheinen); Prigogine, I., Petrosky, T. : ibid. (im Erscheinen); Prigogine, I., Petrosky, T. : Festschrift P. Mazur, Physica (im Erscheinen)

9. Brout, R., Englert, F., Gunzig, E.: Ann. Phys. 115, 78 (1978); Gunzig, E., Nardone, P.: Fundament. Cosmic Phys. 2, 3tl (1987); G6h6niau, J., Prigogine, I. : Found. Phys. 16, 437 (1986); Prigogine, I., G6h6niau, J. : Proc. Nat. Acad. Sci. USA 83, 6245 (1986); Gunzig, E., G6h6niau, J., Prigogine, I. : Nature 330, 621 (1987)